2. Нажмите на пункт «Не запускать на страницах этого домена» и подтвердите действие, нажав на «Исключить».

2. Просто снимите галочку «Включен на этом сайте», текст при этом

изменится на «Отключен на этом сайте», а иконка программы станет серой.

Подпишитесь на нашу рассылку, и станьте одним из тех, кто всегда в курсе всех новостей!

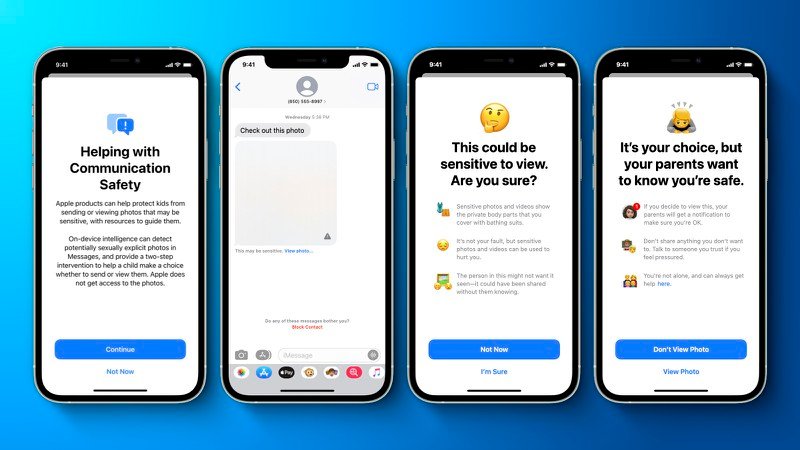

На прошлой неделе Apple анонсировала пару новых функций, направленных на обеспечение безопасности детей, в том числе уведомления iMessage, которые предупреждают детей и родителей о том, что изображение сексуального характера было отправлено или получено на подключенном к iCloud Family Sharing устройстве, автоматическое размытие отправленных в сообщениях откровенных изображений, материалах о сексуальном насилии над детьми, обнаружение технологией CSAM откровенных изображений в библиотеке фотографий iCloud пользователя и многое другое.

Однако вот после анонса новой системы, Apple последовало письмо, которое ссылается на проблему с конфиденциальностью пользователей. Apple не растерялась и незамедлительно опубликовала новый документ с часто задаваемыми вопросами, чтобы внести ясность и прозрачность в ту самую систему CSAM – «расширенную защиту детей».

«Мы хотим защитить детей от маньяков, которые используют средства коммуникации для вербовки и эксплуатации, а также ограничить распространение материалов о сексуальном насилии над детьми (CSAM). С тех пор, как мы объявили об этих функциях, многие заинтересованные стороны, включая организации, занимающиеся вопросами конфиденциальности и безопасности детей, выразили свою поддержку нашего решения», – говорится в документе, добавляя, что компания также получила вопросы о новых функциях, на которые она скоро ответит.

В документе подчеркивается, что безопасность связи в iMessage доступна только для созданных как семьи в iCloud учетных записей, и что сканирование фотографий CSAM применяется только к тем фотографиям, которые пользователь выбирает для загрузки в Фото iCloud, и не работает для пользователей с отключенными фотографиями iCloud.

См. Полный документ Apple о расширенной защите детей здесь.

Отвечая на переживания по поводу того, что правительства вынуждают Apple добавлять не относящиеся к CSAM изображения в список обнаружения, компания заявляет, что откажется от любых таких требований, отметив, что функция обнаружения CSAM построена исключительно для обнаружения известных изображений CSAM, хранящихся в фотографиях iCloud, которые были идентифицированы экспертами NCMEC и других групп по безопасности детей.